Comment fonctionne l’intelligence artificielle ?

Si l’intelligence artificielle est dans notre quotidien depuis le début des années 2000, via les moteurs de recherche, le filtrage automatique des spams ou encore les commandes vocales sur les téléphones portables, son déploiement est devenu spectaculaire en l’espace de quelques années. Aujourd’hui, elle fait parler des assistants personnels intelligents, écrit des poèmes et des articles scientifiques, elle peut même reproduire des voix et créer des images inédites. Ses capacités impressionnantes interrogent. L’IA peut-elle devenir aussi créative qu’un cerveau humain ? Pour y répondre, découvrez quelques éléments clés pour comprendre le fonctionnement de l’intelligence artificielle.

L’intelligence artificielle, c’est quoi exactement ?

L’« intelligence artificielle » évoque une machine qui « pense », à la façon d’un cerveau humain. D’une certaine manière, il est vrai que l’IA (et principalement l’IA générative) cherche à imiter l’intelligence humaine, sans toutefois y parvenir.

Techniquement parlant, l’intelligence artificielle n’est ni une machine, ni un modèle en soi. Elle consiste à programmer un système informatique qui imite une grande partie des fonctions cérébrales humaines. Ces fonctions qu’on qualifie généralement « d’intelligence ».

Toute la difficulté de la question est là : comment définir l’IA, s’il est déjà compliqué de savoir ce qui définit l’intelligence humaine ? De nombreux scientifiques, experts, philosophes et psychologues ont essayé (et même si certains avis convergent) tous n’en ont pas la même vision.

Qu’appelle-t-on l’intelligence, exactement ? Si on mesure uniquement le nombre de connexions neuronales possibles dans le cerveau, alors l’IA est effectivement une bonne réplique de l’intelligence humaine. Mais qu’en est-il du reste des facultés cognitives humaines ? De la perception, l’attention, la compréhension et la gestion des émotions, auxquelles l’IA ne peut pas du tout prétendre ? C’est ce qui différencie déjà de façon radicale l’IA de l’humain : elle n’a pas de conscience propre ni de pensée autonome.

Qui a inventé l’intelligence artificielle ?

L’expression « intelligence artificielle » émerge à la fin des années 1950, dans la voix du mathématicien américain John McCarthy. Il vient alors d’inventer un programme de jeu d’échecs avec ses étudiants. Leur création peut pour la première fois jouer une partie toute seule. Dans les grandes lignes, son équipe et lui ont écrit un langage spécifique qui traduit des schémas de connexions neuronales (comme en produit le cerveau humain) sous forme de programmes informatiques. Si le résultat est impressionnant, McCarthy reconnaît déjà à l’époque que même en imitant les raisonnements humains, l’IA est encore loin de pouvoir couvrir toutes les subtilités de l’intelligence humaine.

Il n’est pas le seul à orienter ses recherches depuis longtemps sur ce sujet. De très nombreux chercheurs ont développé depuis cette époque des algorithmes et autres techniques d’apprentissage automatique, réseaux neuronaux artificiels, arbres de décisions, etc., qui ont été intégrés petit à petit à toutes les machines.

Attention l’IA n’est pas un robot !

Avec l’IA, on parle de « langages » et de « programmes », mais pas de robots. Il ne s’agit pas encore de formes d’êtres humains suprêmement évolués, ni de machines autonomes… Il faut bien distinguer l’intelligence artificielle du support qu’elle complète (de l’ordinateur à l’ampoule connectée, en passant par du matériel médical, militaire ou audiovisuel).

L’IA rend de précieux services à son usager, quand elle lui permet de gagner en précision par exemple. Dans le domaine médical, l’IA a notamment permis d’optimiser les scanners d’imagerie existants avec la détection ultra-rapide des anomalies, l’amélioration de la qualité des images, l’accélération du processus avec réduction de l’exposition des patients aux rayonnements, etc.

Une machine plus performante, mais pas plus humaine

L’intelligence artificielle semble humaniser désormais certaines machines en leur donnant une apparence de « réflexion ». C’est ce qui floute les limites, à l’instar de la voiture autonome, capable de percevoir son environnement (au moyen de capteurs et radars), de prendre une « décision » rapide (grâce à des algorithmes qui analysent la situation) et d’ajuster sa conduite à une situation changeante. En revanche, la voiture ne « pense » pas. Elle ne peut donc pas comprendre le contexte, lire ni anticiper les réactions des autres usagers de la route en temps réel. Par exemple, elle ne saurait pas interpréter l’hésitation d’un piéton sur le point de traverser. Ces subtilités typiquement humaines lui sont inaccessibles. C’est pourquoi l’IA d’une voiture autonome a encore tendance à prendre les mauvaises « décisions », malgré une programmation toujours plus pointue.

Qu’y a-t-il sous le capot d’une IA ?

Pour tenter d’imiter un cerveau humain, l’IA doit réunir trois ingrédients majeurs.

1 – La data, pour se nourrir d’informations

L’intelligence humaine repose en partie sur la richesse des informations gravitant dans notre cerveau. Chez l’humain, ces informations peuvent être des perceptions sensorielles (choses vues, touchées, entendues, etc.), des souvenirs, des réflexions et des informations traitées au fil du temps, ou des données plus « techniques » comme les signaux électriques et chimiques échangés entre les neurones, ou entre le cerveau et le reste du corps pour contrôler les mouvements. Chez l’IA, l’intelligence provient d’une grande quantité de données. Plus l’IA est capable d’engranger des données, plus son intelligence se développe.

2 – La puissance informatique, pour traiter ces informations

L’intelligence humaine repose également sur les capacités de traitement de toutes ces informations par notre cerveau, les capacités de connexion et d’analyse.

Pour imiter son fonctionnement, l’IA a besoin d’une énorme puissance informatique pour exploiter et traiter les données qu’elle est capable d’engranger.

3 – Le réseau d’algorithmes, pour développer ces informations et progresser en continu

Enfin, ce qui fait l’incroyable performance intellectuelle humaine, c’est aussi le réseau complexe entre les neurones, sa capacité d’apprentissage et d’adaptation, de distribution et de hiérarchisation de l’information. Pour l’IA, ce réseau s’est matérialisé en un ensemble d’algorithmes, capables à leur tour de traiter, catégoriser, analyser et comprendre les données.

Plusieurs disciplines scientifiques sont à l’origine de l’IA. Entre autres, les mathématiques et les sciences cognitives (qui s’intéressent au fonctionnement du cerveau, à des choses comme la perception, l’attention, la mémoire, le langage, la résolution de problème ou encore la prise de décision). Mais aussi une discipline beaucoup plus récente : la neurobiologie computationnelle. Là, il s’agit plutôt de comparer les modèles informatiques à notre cerveau. Autrement dit, de partir de l’ordinateur et sa mécanique, pour analyser, comprendre et même prédire ce qui se passe dans le cerveau.

Les algorithmes utilisés pour le développement de l’IA s’appuient sur plusieurs méthodes et technologies, comme :

- L’apprentissage automatique (ou machine learning) : dans l’informatique traditionnelle, les programmes répondent à des instructions précises, écrites dans le code. Avec l’apprentissage automatique, la machine apprend par mouvement d’essai-erreur. À partir des données collectées, elle est capable d’affiner ses connaissances au fur et à mesure.

Par exemple, à force de montrer des images de chats à une IA, on lui apprend à identifier ces félins. D’ailleurs, en cliquant sur les images de bus, de feux rouges, de motos ou de chats dans les « captchas », les utilisateurs aident en fait manuellement l’IA à pratiquer leur machine learning. - L’apprentissage en profondeur (ou deep learning) : va encore plus loin que l’apprentissage automatique en imitant les réseaux neuronaux du cerveau humain. Le machine learning nécessite l’intervention humaine, alors que le deep learning s’en affranchit. Avec le deep learning, une machine est capable de traiter des données complexes, sans qu’elles aient été traitées par des humains.

Un exemple de deep learning : la fameuse VSA ou vidéosurveillance algorithmique. On dispose d’un réseau de caméras de surveillance (autour d’un stade sportif ou à des sorties de métro) pour assurer la sécurité des lieux. On programme ensuite les algorithmes d’une IA pour collecter, trier et analyser les images, en identifiant les visages humains, les voitures, les animaux de compagnie, etc. L’IA peut ainsi détecter, dans la foule d’images collectées en direct, des visages de personnes fichées par les services de sécurité, ou des comportements dangereux qui nécessitent une intervention policière. Ces systèmes ont été installés à Paris pour les JO 2024, mais ils soulèvent toujours la question polémique de savoir comment identifier un « comportement dangereux ». On touche ici aux problèmes de subtilité, d’exhaustivité et de neutralité des données nourrissant l’IA. - Le traitement du langage naturel (ou natural language processing) : il s’agit de techniques qui permettent aux machines de comprendre le langage humain et d’y répondre naturellement. On entre là dans l’univers des assistants vocaux comme Alexa, Siri ou Google Assistant, ou des applications de traduction instantanée. Parmi les applications les plus populaires de cette technique, on trouve les compagnons virtuels, comme Replika, MAI Friend ou CharacterAI, qui permettent de dialoguer à voix haute avec une célébrité ou avec un ami fictif.

- La vision numérique ou vision par ordinateur (ou computer vision) : c’est une technique qui permet aux machines de comprendre les données visuelles. Cette technique est souvent couplée au machine learning, notamment dans des applications de vidéosurveillance (comme la VSA évoquée plus haut). On peut aussi la retrouver sur des chaînes de montage en usine, où l’analyse vidéo en direct sert à inspecter les défauts, les irrégularités ou les anomalies de production sur les pièces, pour en améliorer la qualité.

Et ChatGPT dans tout ça ?

ChatGPT est une IA générative, c’est-à-dire qui crée du contenu. Ce type d’IA s’appuie sur les techniques d’apprentissage automatique. Elle moissonne un nombre incalculable de données, les trie et les analyse ensuite pour répondre à une demande que l’utilisateur lui pose à l’écrit. Elle produit généralement un contenu cohérent avec la demande.

Toutefois, même si certains contenus semblent satisfaisants, une vérification est systématiquement nécessaire. L’IA recycle les informations qu’elle a à sa disposition et toutes ne se valent pas. Elle ne sait pas les remettre en doute et, pire encore, elle a tendance à produire des réponses trompeuses sans prévenir. C’est pourquoi il faut prendre le temps de bien se former pour utiliser l’IA générative au service d’un contenu web.

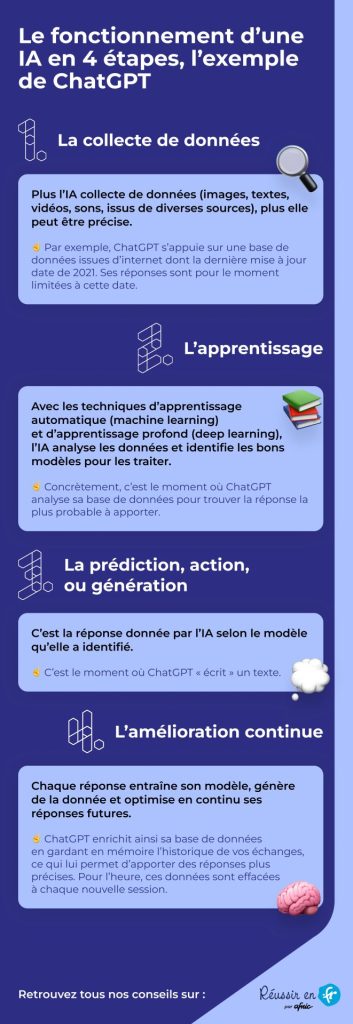

Comment fonctionne l’IA : les 4 phases

Le fonctionnement d’une IA peut être schématisé en 4 grandes phases.

- La collecte de données : l’IA puise dans un ensemble d’informations (images, textes, vidéos, sons, etc.) provenant des diverses sources auxquelles on lui donne accès. Plus elle peut collecter de données, plus l’IA peut être précise. Par exemple, une IA utilisée pour affiner le diagnostic dans un cabinet médical pourrait utiliser les dossiers médicaux des patients, les données d’imagerie (scanners, IRM, échographies, etc.), mais aussi les données de santé publique et les publications médicales récentes, ainsi que toute la base de savoir médical qu’on pourrait lui mettre à disposition

- La phase d’apprentissage : avec les techniques d’apprentissage automatique et d’apprentissage profond, l’IA analyse les données et identifie les bons modèles pour les traiter. D’une certaine manière, l’IA s’entraîne à connecter les informations entre elles pour apprendre à les reconnaître, puis les analyser, les comprendre… et enfin, à les exploiter.

- La phase de prédiction, et d’action ou de génération : à ce stade, l’IA propose une réponse qui semble être la plus appropriée selon le modèle qu’elle a identifié. Avec une IA générative, comme Chat-GPT, par exemple, c’est le moment où l’IA « écrit » un texte.

- L’amélioration continue : on peut aujourd’hui programmer une IA pour qu’elle continue à collecter automatiquement des données, qu’elle continue à entraîner son modèle et optimise en continu ses réponses futures. Elle s’améliore donc d’elle-même, tant que ses programmateurs lui demandent de le faire.

L’IA va-t-elle bientôt nous remplacer ?

Si elle travaille déjà parmi nous depuis longtemps, son omniprésence ces dernières années est source d’inquiétude pour beaucoup. Pour se préparer à un futur avec l’IA, voici quelques clés de compréhension de son développement :

- L’intelligence artificielle étroite : aujourd’hui, nous en sommes là. C’est-à-dire que nous utilisons une IA programmée pour une tâche précise. Elle ne prend pas de décisions de manière autonome, elle dépend des cadres algorithmiques qui ont été définis pour elle. En clair, l’IA procède totalement de l’humain qui la contrôle.

- L’intelligence artificielle forte : nous n’y sommes pas encore, mais c’est un objectif. Chercheurs et experts travaillent à développer une forme d’IA au moins égale ou supérieure à l’intelligence humaine (dans plusieurs domaines cognitifs). Ce qui voudrait dire, entre autres, qu’elle serait capable d’apprendre, de raisonner, de comprendre et d’accomplir des tâches par elle-même.

- La super-intelligence artificielle : on entre là dans un chapitre presque futuriste. Cette super IA dépasserait de loin l’intelligence humaine et aurait donc la capacité de se développer elle-même. Cela poserait des questions éthiques (pourrait-on encore considérer l’IA comme un programme informatique ?) et des problèmes sécuritaires (comment contrôler une forme d’intelligence qui nous dépasse ?). Mais c’est un futur très hypothétique, jugé improbable pour le moment par les experts.

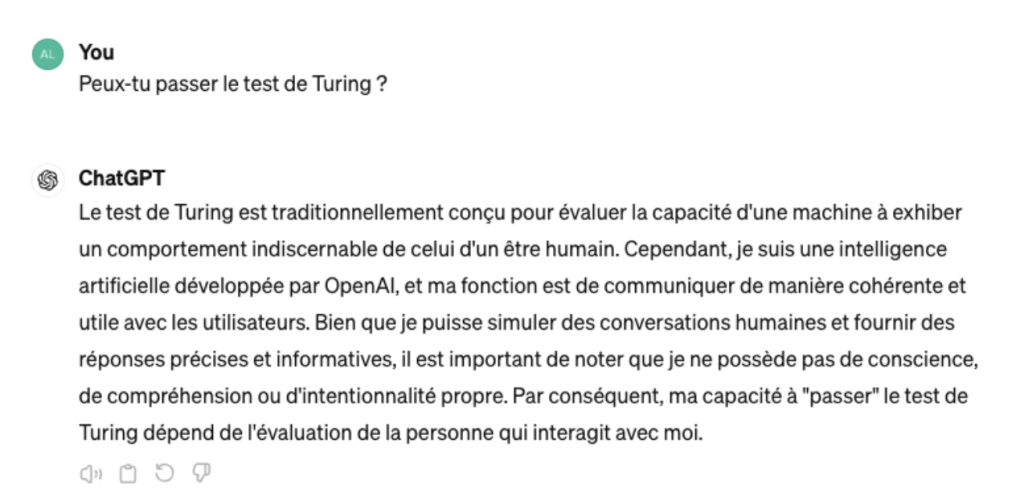

Connaissez-vous le test de Turing ?

Alan Turing a inventé cette méthode pour déterminer si la capacité de raisonnement d’une machine est égale à celle d’un humain.

Son principe est simple : mettre en communication à l’aveugle une personne avec deux interlocuteurs, dont l’un est une machine. Si la personne ne parvient pas à déterminer lequel des deux est une machine, le test est considéré comme réussi. L’intelligence de la machine se confond avec celle de l’humain.

On pourrait croire que certaines formes d’IA l’auraient réussi à ce jour… Mais ce n’est pas le cas ! Chat-GPT, par exemple, échoue toujours et prévient de son possible échec quand on le lui demande.

Exemple réalisé avec Chat-GPT, avril 2024

Faut-il avoir peur de l’intelligence artificielle ?

Allons-nous devenir obsolètes ? L’IA pourrait-elle nous contrôler ou nous faire du mal ? Ce n’est pas encore au programme. Pour l’heure, l’IA fait encore beaucoup d’erreurs liées aux défauts de ses systèmes (mauvaise représentativité, hypothèses trop approximatives, etc.) ou de ses conditions d’utilisation (environnement trop bruyant pour les assistants vocaux, etc.). La technologie avance vite, mais elle connaît encore des limites.

Il faut systématiquement vérifier tout ce que produit l’IA. D’une part, elle a tendance à donner des réponses trompeuses. Cela se produit en partie par défaut de programmation (ce qui peut être corrigé), mais également parce qu’elle ne sait pas interpréter et qu’elle manque de subjectivité (une spécificité de l’être humain). D’autre part, ses productions sont souvent biaisées ou discriminantes, notamment parce que les données de départ l’étaient, ou que les modèles choisis n’étaient pas pertinents. En bref, l’IA souffre à la fois des biais humains… et de ne pas pouvoir faire preuve, elle-même, d’un jugement comme le nôtre.

C’est notamment pour ces raisons que l’IA n’est pas encore prête à remplacer l’humain, même si elle produit de plus en plus de contenus de qualité.

Par ailleurs, l’IA n’est toujours pas capable de se gérer elle-même. Elle en est même très loin ! La conception, l’entraînement et le choix de déploiement de l’IA dépendent totalement des humains. Avant d’avoir peur de l’IA en tant que telle, il faut donc commencer par questionner la chaîne de commandement et les décisions humaines, car c’est là où se logent toutes les responsabilités.